robots.txtの更新は1日程度反映されないので公開前には注意を

2016/04/25

robots.txtにクローラー除外設定を施した際、記述を削除しても更新反映に時間がかかったので備忘録として。

サイトのオープン前やページの公開前など、クローラーにインデックスされたくないなどで

robots.txtに以下を記述した場合

User-Agent: *

Disallow: / クローラーに上記記述のrobots.txtがクローリングされてしまうと

記述内容を削除してもすぐにはサイト、ページをインデックスさせることができない。

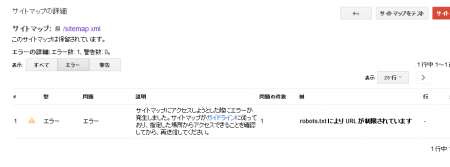

Googleウェブマスターツールからサイトマップの送信を行なっても

エラー表示されてしまう。

説明:

サイトマップにアクセスしようとした際にエラーが発生しました。サイトマップがガイドラインに従っており、指定した場所からアクセスできることを確認してから、再送信してください。

例:

robots.txt により URL が制限されています

「Fetch as Google」からURLを送信しても

robots.txt により拒否されました

と表示される。以下エラー表示内容

このページは Googlebot によりダウンロードされた最新の robots.txt ファイルでブロックされているため、この時にクロールできませんでした。最近 robots.txt ファイルを更新した場合は、ファイルが最新の状態になるまで最大 2 日ほどかかる場合があります。robots.txt について詳しくは、こちらのヘルプセンターの記事をご覧ください。

結果

更新反映には1日程度かかるのでサイトの公開や、ページの公開前にはrobots.txtの記述は

削除しておく。

どうしてもページを表示させたくない場合は

.htaccessなどでベーシック認証をかけて対応する。

実際に確認したところ、

robots.txtの記述を解除し、サイトマップを送信しておけば

ウェブマスターツールの表示が通常に戻るよりも先にページのインデックスは行われている。

ウェブマスターツールの表示にはズレが生じるようです。

追記:2016.04.25

現在ではrobots.txtの更新がサーチコンソール内で行えます。

「robots.txtテスター」の画面の「送信」ボタンをクリックすると、

1、更新されたコードをダウンロード

2、アップロードされたバージョンを確認

3、Google に更新をリクエスト

と表示されます。更新したい場合は、3を選択して送信するとrobots.txtを更新してもらえます。